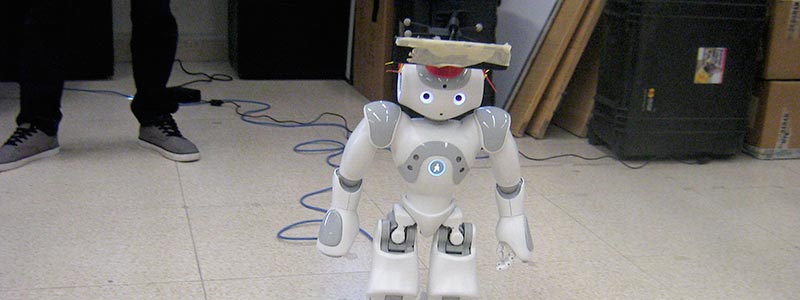

Saltillo, Coahuila. (Agencia Informativa Conacyt).- Científicos del Centro de Investigación y de Estudios Avanzados (Cinvestav) del Instituto Politécnico Nacional (IPN), unidad Saltillo, desarrollaron un método de localización para robots humanoides orientado a tareas de locomoción mediante reconstrucción de imágenes 3D (tercera dimensión).

Este proyecto presenta un método de localización activo, basado en información visual para controlar la locomoción de un robot humanoide.

“Si yo tengo imágenes obtenidas mediante una cámara, la parte visual, buscamos relacionar estas imágenes con el conocimiento de dónde se encuentra posicionado un agente robótico. Esa imagen de alguna manera me puede hacer saber dónde está la cámara que lo tomó y, por ende, dónde se encuentra el robot”, explicó el doctor Mario Castelán, profesor investigador titular del grupo de Robótica y Manufactura Avanzada del Cinvestav Saltillo y coordinador del proyecto.

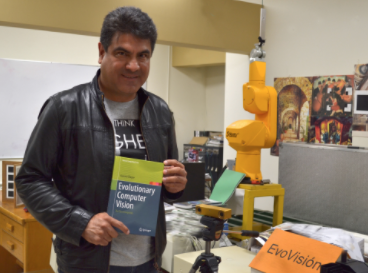

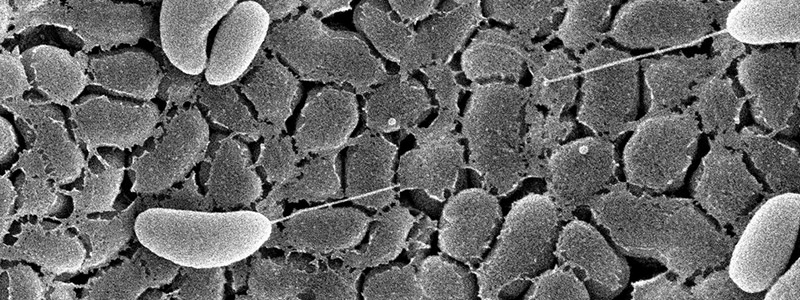

Doctor Mario Castelán.A partir de una secuencia de video monocular adquirida por una cámara montada en el robot, es posible dirigir la trayectoria de este alrededor de un objeto de interés para estimar su geometría. Teniendo una localización precisa, el robot podrá cumplir su tarea de forma adecuada.

Doctor Mario Castelán.A partir de una secuencia de video monocular adquirida por una cámara montada en el robot, es posible dirigir la trayectoria de este alrededor de un objeto de interés para estimar su geometría. Teniendo una localización precisa, el robot podrá cumplir su tarea de forma adecuada.

“Hemos trabajado localización visual de robots humanoides, buscando hacer que el robot conozca el mundo con el que interactúa, en este caso con los objetos, y cómo puede moverse sabiendo exactamente en dónde se encuentra. Lo anterior con el fin de generar reconstrucciones muy precisas de objetos en el entorno del robot. Las dimensiones estimadas deben respetar las dimensiones físicas reales de los objetos, incluso si la superficie de estos presenta variaciones complejas”, precisó el investigador.

De acuerdo con el doctor Castelán, uno de los problemas de la visión robótica es localizar la cámara que tomó la imagen y para esto siempre hay que tener una referencia.

“Trabajamos en la localización absoluta, que tiene que ver con un referente absoluto y exacto. La cámara que tiene el robot, es decir los ojos del robot humanoide, presenta información visual que ayuda a calcular de manera muy precisa (a nivel de milímetros) su posición y orientación. Si no se recupera adecuadamente la posición y orientación de la cámara, no se formarán reconstrucciones 3D de objetos con dimensiones bien estructuradas”, detalló el científico.

La referencia absoluta alude a un punto que no cambia, por ejemplo, para los humanos en una recámara, la referencia absoluta puede ser la cama. Para un robot, es un punto que tiene sentido en términos matemáticos, como podría ser la esquina de una habitación.

Este desarrollo presenta un enfoque que incluye un conjunto de criterios estadísticos para el análisis del mapa 3D y sus puntos 2D (segunda dimensión o plano de la imagen) reproyectados, el cual es novedoso para tareas de locomoción y de gran utilidad para orientar al robot hacia diferentes direcciones con suficiente información visual.

Visión y orientación

Visión y orientación

Con la referencia absoluta, el robot se convierte en un vector, es decir una especie de segmento que puede ubicar su posición en sentido de los ejes X, Y y Z. En el cual X y Y localizan al robot (por ejemplo, en el piso) y Z es utilizado para la altura de la cámara. Otro dato indispensable a recuperar es la orientación, la cual se da en ángulos dependiendo de la referencia absoluta o de la misma cámara. Para que el robot pueda moverse e interactuar, necesita este tipo de posicionamiento y dar sentido a su desplazamiento al conocer las dimensiones reales de los objetos a través de una cámara bien calibrada.

Esta investigación ha derivado además en una colaboración con la Universidad Politécnica de Cataluña, a través de un proyecto de monitoreo de la trayectoria para un robot humanoide basado en información de profundidad, integrado a un esquema de control que considera una posición y orientación objetivo, mientras se actualizan las velocidades lineal y angular del robot humanoide en una estrategia de comunicación basada en el Sistema Operativo Robótico (ROS, por sus siglas en inglés).

El doctor Castelán visualiza este desarrollo con potencial de aplicación en robots que actúen en espacios pequeños y robots humanoides de servicio que interactúen con humanos y puedan adaptarse a los pequeños cambios en los espacios habitados por personas, con la manipulación inteligente de objetos que pueden cambiar de lugar como un vaso, maceta, etcétera.

“Buscaremos la localización a mayor escala y trabajar con robots con ruedas, ya que los humanoides son bípedos. Sería interesante interactuar con investigadores del área de interacción humano-robot para relacionar algoritmos de visión que están basados en teorías matemáticas con aplicaciones que tienen que ver con teorías del comportamiento”.

El especialista añadió que la tendencia en esta área de estudio es la fusión de datos obtenidos a través de cámaras modificadas con otros sensores, como el infrarrojo, láser y GPS, que auxilien en la determinación de otros aspectos de localización para proporcionar mayor autonomía a los robots móviles.

AUTOR: Felipe Sánchez Banda

FUENTE: AGENCIA INFORMATIVA CONACYT